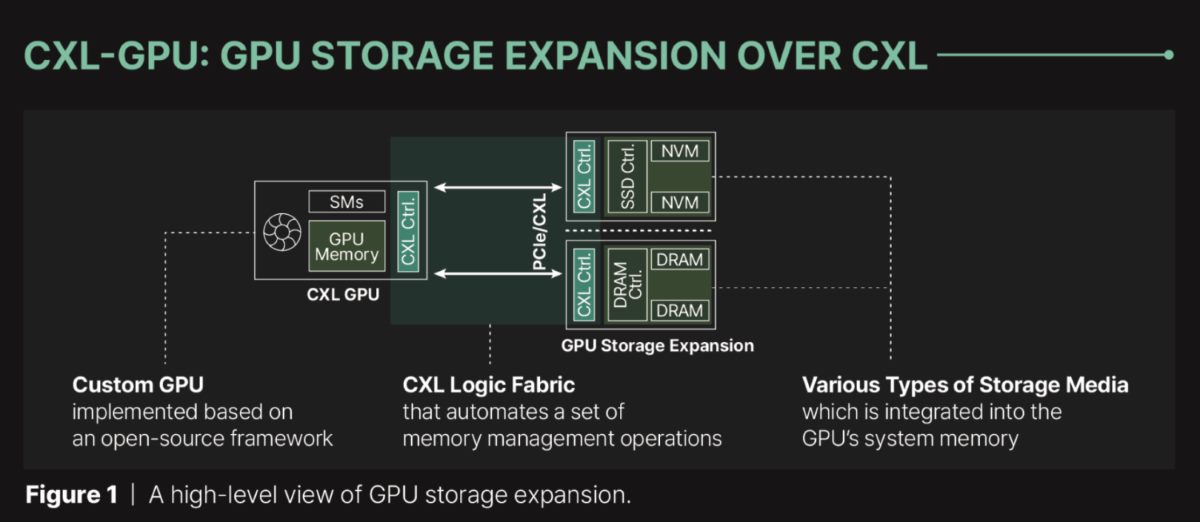

Das Unternehmen Panmnesia hat eine innovative Lösung auf Basis des CXL-Protokolls (Compute Express Link) entwickelt, um den Speicher von Grafikkarten zu erweitern. Diese Lösung kann sowohl DRAM als auch NAND per PCI-E und SSDs nutzen. Das CXL-Protokoll, unterstützt von einem breiten Industriekonsortium, zielt darauf ab, CPUs, GPUs und FPGAs näher zusammenzubringen. Bereits 2021 hatte Samsung einen möglichen Anwendungsfall der Speichererweiterung über PCI-Express vorgestellt.

Panmnesia hat nun eine CXL-Lösung mit geringer Latenz präsentiert, die vor allem Grafikprozessoren für KI- und HPC-Anwendungen zugutekommen könnte, da diese oft nur über begrenzten High-Bandwidth-Memory (HBM) verfügen. Panmnesia, unterstützt vom renommierten südkoreanischen KAIST-Forschungsinstitut, stand dabei vor der Herausforderung, CXL für die GPU-Speichererweiterung zu integrieren, da es keine CXL-Logikstruktur oder Subsysteme gibt, die DRAM- oder SSD-Endpunkte für GPUs unterstützen. Grafikprozessoren erkennen normalerweise keine Speichererweiterungen außer Unified Virtual Memory (UVM), das als langsam gilt. Daher muss die Technologie von einem anwendungsspezifischen integrierten Schaltkreis (ASIC) und seinem Subsystem erkannt werden. Ein einfacher CXL-Controller reicht nicht aus, um die Technologie insbesondere bei GPUs verwenden zu können.

Um diese Hürde zu überwinden, hat der Hersteller einen CXL 3.1-kompatiblen Root-Komplex (RC) entwickelt, der über mehrere Root-Ports (RP) verfügt und externen Speicher über PCI-E unterstützt. Dazu kommt eine Host-Bridge mit einem HDM-Decoder (Host-managed Device Memory), der mit dem Systembus der GPU verbunden ist. Der HDM-Decoder verwaltet die Adressbereiche des Systemspeichers, sodass das Speichersubsystem der GPU glaubt, mit Systemspeicher zu arbeiten, während tatsächlich per PCI-E verbundener DRAM oder NAND genutzt wird. So könnten beispielsweise DDR5-RAM oder SSDs als Erweiterung des GPU-Speicherpools dienen.

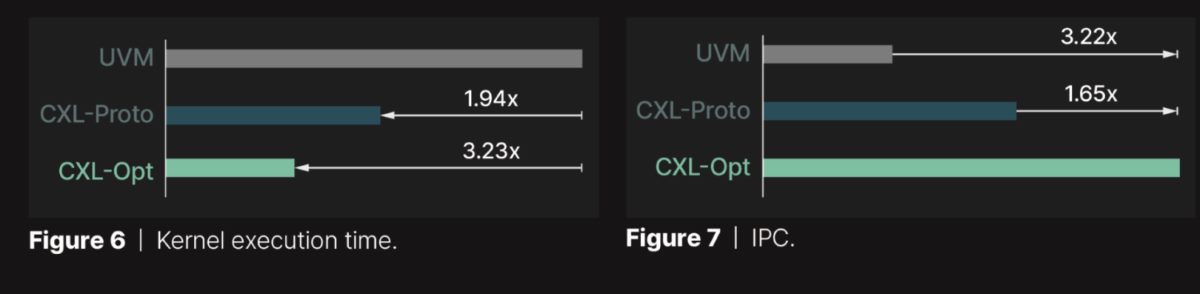

Panmnesias Technik soll eine Latenzzeit im zweistelligen Nanosekundenbereich aufweisen, was deutlich schneller ist als der von Samsung entwickelte Prototyp. Aufgrund des geringen Overheads und des direkten Zugriffs auf den erweiterten Speicher über Lade-/Speicherbefehle ist die Ausführungszeit von der entwickelten Lösung erheblich kürzer als bei UVM.

Die CXL-Unterstützung birgt großes Potenzial für KI/HPC-GPUs. Es bleibt jedoch abzuwarten, ob Unternehmen wie AMD und Nvidia diesen Support in ihre GPUs integrieren werden. Sollte sich der Ansatz der Nutzung von PCI-E-Speicher für GPUs durchsetzen, stellt sich die Frage, ob die Hersteller proprietäre Lösungen wie die von Panmnesia verwenden oder ihre eigene Technologie entwickeln werden. AMD hat angekündigt, CXL in den nächsten drei bis fünf Jahren auch in Desktop-Chips zu integrieren.